K (→Kalibrierungsmuster: git repo) |

|||

| Zeile 46: | Zeile 46: | ||

Die Marker werden im Kinect-Bild erkannt und mit der bekannten Tiefe können ihnen 3d-Positionen zugeordnet werden. Diese Positionen werden dann in Tischkoordinaten (x,y,0) umgerechnet, und damit die Projektionsmatrix berechnet. | Die Marker werden im Kinect-Bild erkannt und mit der bekannten Tiefe können ihnen 3d-Positionen zugeordnet werden. Diese Positionen werden dann in Tischkoordinaten (x,y,0) umgerechnet, und damit die Projektionsmatrix berechnet. | ||

Soll dann ein bestimmes Bild auf dem Tisch angezeigt werden, kann darüber die auszugleichende Verzerrung berechnet werden. | Soll dann ein bestimmes Bild auf dem Tisch angezeigt werden, kann darüber die auszugleichende Verzerrung berechnet werden. | ||

Weiter Bilder auch im [https://github.com/NikolasE/Touchpad github]. | |||

=== Erkennung der Nutzerinteraktion === | === Erkennung der Nutzerinteraktion === | ||

Über die Tiefenwerte wird eine Ebene in den Tisch gefittet. Für jeden Punkt, den die Kinect sieht, kann damit der Abstand der Ebene und der nächste Punkt in der Ebene berechnet werden. Sobald ein Punkt sehr nahe am Tisch ist, kann ein MouseDown ausgelöst werden, und das Object verfolgt werden, bis es sich wieder vom Tisch entfernt, was dann ein MouseUp darstellt. Bewegt sich ein Objekt nahe der Oberfläche (2-20cm) könnte auch ein MouseOver ausgegeben werden. | Über die Tiefenwerte wird eine Ebene in den Tisch gefittet. Für jeden Punkt, den die Kinect sieht, kann damit der Abstand der Ebene und der nächste Punkt in der Ebene berechnet werden. Sobald ein Punkt sehr nahe am Tisch ist, kann ein MouseDown ausgelöst werden, und das Object verfolgt werden, bis es sich wieder vom Tisch entfernt, was dann ein MouseUp darstellt. Bewegt sich ein Objekt nahe der Oberfläche (2-20cm) könnte auch ein MouseOver ausgegeben werden. | ||

Aufgaben hier wäre hier eine möglichst glatte Mausbewegung und eine Erkennung der verschiedenen Events. Da der Tisch multitouch-fähig sein soll, müssen auch mehrere Objekte gleichzeitig getrackt werden. (z.B. für eine Zoom-Geste mit zwei Händen). | Aufgaben hier wäre hier eine möglichst glatte Mausbewegung und eine Erkennung der verschiedenen Events. Da der Tisch multitouch-fähig sein soll, müssen auch mehrere Objekte gleichzeitig getrackt werden. (z.B. für eine Zoom-Geste mit zwei Händen). | ||

Version vom 24. Februar 2012, 01:46 Uhr

Riesentouchpad aus Beamer und Kinect

Ich würde gerne ein großes Touchpad aus einem Beamer und einer Kinect bauen. Mit dem Beamer kann man beliebige Bilder auf den Boden, einen Tisch oder eine Wand projizieren, mit der Kinect kann man feststellen, wenn jemand die Fläche berührt. Interaktive Hüpfkästchen oder ein interaktiver Tisch wären damit dann schnell machbar.

Die Technik dahinter ist nichts Neues, nur habe ich bisher keine OpenSource Lösung für diese Anwedung gesehen und ich glaube, dass man mit dieser Riesen-Touchpad viel Spaß haben kann.

Alleine zu Arbeiten ist langweilig, daher suche ich noch Leute, die mitspielen wollen. Es gibt zwei große Bereiche, in denen man sich austoben kann:

- Bau des eigentlichen Touchpads

- Entwicklung von Spielen/Anwendungen für das Touchpad

Damit auch schon bei der GPN etwas vorzeigbares rauskommt, werde ich schon im Vorfeld einen Prototypen bauen.

Wer also schon immer mal mit der Kinect arbeiten wollte, vielleicht etwas über Bildverarbeitung lernen will oder auch ein Spiel für eine 4m^2 große interaktive Wand schreiben will, ist herzlich eingeladen, bei dem Projekt mitzumachen. Kommentare, Fragen, usw. am besten auf die Diskussionsseite hier.

Nikolas 01:13, 24. Feb. 2012 (CET)

Bau des Touchpads

Da der Beamer meist nicht direkt über dem Feld installiert werden kann, wird das Bild recht stark verzerrt werden, was algorithmisch ausgeglichen werden sollte. Zudem muss klar sein, welches Pixel angesprochen werden muss, wenn ein bestimmter Fleck auf dem Tisch seine Farbe wechseln soll. Daher ist es notwendig, die Position des Beamers und der Kinect relativ zum Tisch zu bestimmen. Für die Kinect mit der Tiefeninformation ist das recht einfach machbar, für den Beamer muss man dann etwas Mathe rausholen. Für die Beamerkalibrierung (Bestimmung der Projektionsmatrix/Homographie) kann man den Beamer als inverse Kamera betrachten und über die normalen markerbasierten Algorithmen gehen.

Kalibrierungsmuster

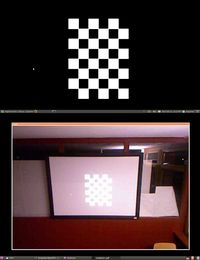

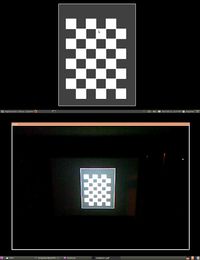

Hier ein paar Möglichkeiten für Kalibrierungsmuster. Die Kinect stand direkt auf dem Beamer. Der Raum war unterschiedlich stark ausgeleutet, der automatische Weißabgleich der Kinect lässt sich leider nicht ausschalten. Helle Muster wie das Schachbrett sind daher vielleicht nicht optimal, kleine Kreise sind da vll besser. Die obere Hälfte ist jeweils das Bild, das der Beamer anzeigt und darunter das Kinectbild.

Die Marker werden im Kinect-Bild erkannt und mit der bekannten Tiefe können ihnen 3d-Positionen zugeordnet werden. Diese Positionen werden dann in Tischkoordinaten (x,y,0) umgerechnet, und damit die Projektionsmatrix berechnet. Soll dann ein bestimmes Bild auf dem Tisch angezeigt werden, kann darüber die auszugleichende Verzerrung berechnet werden. Weiter Bilder auch im github.

Erkennung der Nutzerinteraktion

Über die Tiefenwerte wird eine Ebene in den Tisch gefittet. Für jeden Punkt, den die Kinect sieht, kann damit der Abstand der Ebene und der nächste Punkt in der Ebene berechnet werden. Sobald ein Punkt sehr nahe am Tisch ist, kann ein MouseDown ausgelöst werden, und das Object verfolgt werden, bis es sich wieder vom Tisch entfernt, was dann ein MouseUp darstellt. Bewegt sich ein Objekt nahe der Oberfläche (2-20cm) könnte auch ein MouseOver ausgegeben werden. Aufgaben hier wäre hier eine möglichst glatte Mausbewegung und eine Erkennung der verschiedenen Events. Da der Tisch multitouch-fähig sein soll, müssen auch mehrere Objekte gleichzeitig getrackt werden. (z.B. für eine Zoom-Geste mit zwei Händen).